Les chatbots, ou agents conversationnels reposant sur des algorithmes d’intelligence artificielle (IA) façon ChatGPT, nécessitent d’être entraînés sur un nombre de données toujours plus grand. Un entraînement qui nécessite une énorme puissance de calcul, comme l’a récemment confirmé Elon Musk.

Les énormes besoins de Grok 3

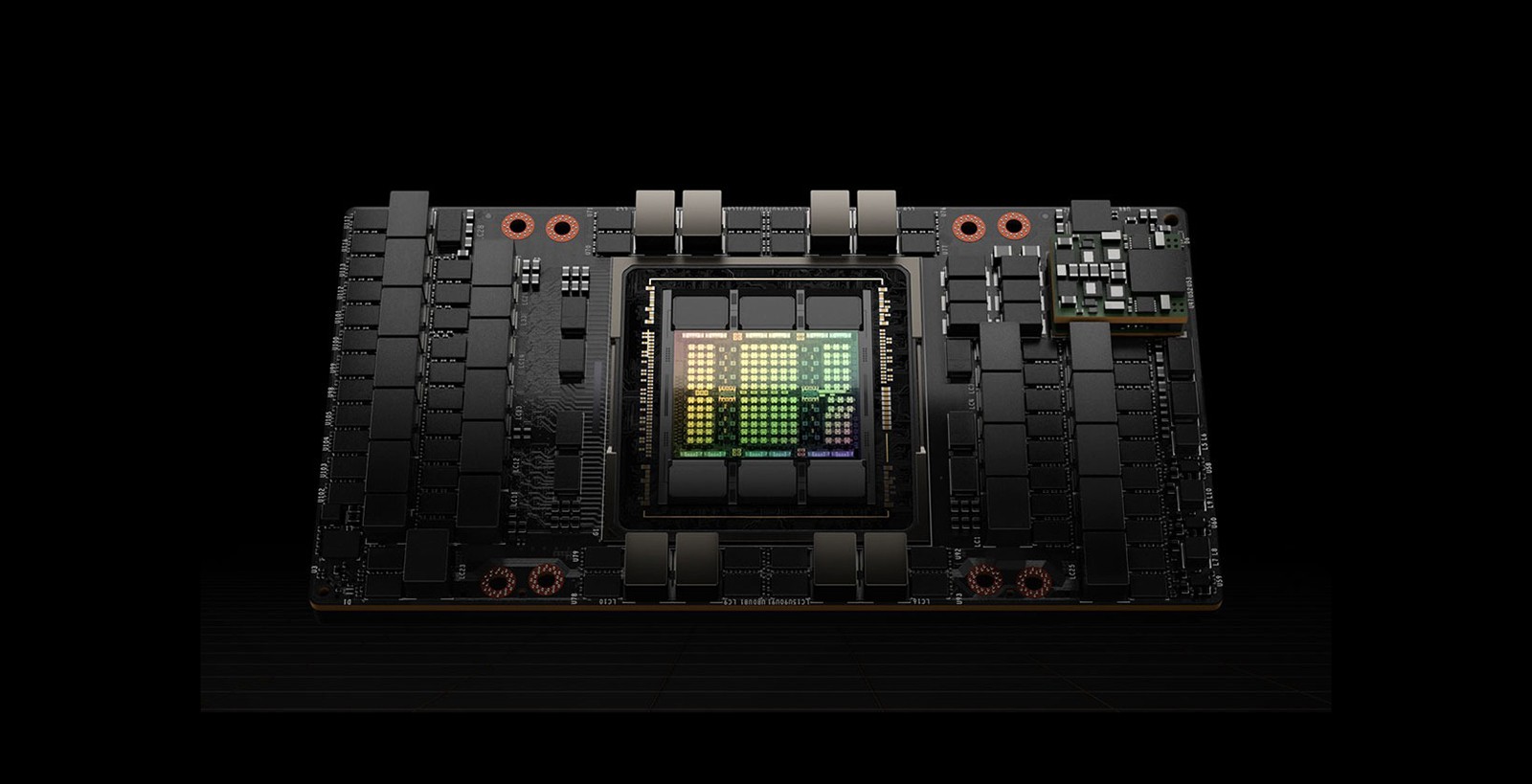

Propriétaire de X, PDG et fondateur de multiples compagnies innovantes parmi lesquelles Tesla et Space X, Musk avait annoncé l’année dernière le premier produit de sa société xAI, créée plus tôt en 2023 : un chatbot nommé Grok (ce nom, quand même…). L’entrepreneur a récemment déclaré que Grok 2 avait nécessité 20 000 GPU Nvidia H100 pour son entraînement, et d’ajouter qu’il en faudra 100 000 pour atteindre la puissance nécessaire à l’entraînement de la prochaine version, Grok 3.

En janvier, Musk avait déclaré avoir investi 500 millions de dollars pour son super calculateur Dojo, soit l’équivalent de 10 000 processeurs nVidia H100, et d’ajouter : « Tesla dépensera beaucoup plus cette année pour du matériel nVidia. Les enjeux de base pour être compétitif dans le domaine de l'IA sont actuellement d'au moins plusieurs milliards de dollars par an ».